“On a qu’à faire un A/B test”. Combien de fois avez-vous déjà entendu cette phrase, au moment de sortir une campagne e-mail, une nouvelle version du site web ou un formulaire de conversion ? Dans toutes les entreprises, les A/B tests se répandent à la vitesse de l’éclair. L’idée : comparer l’efficacité entre deux versions d’un même contenu digital.

Mais est-ce une stratégie efficace ? Surtout en B2B ? Est-ce (vraiment) un levier pertinent, quand on est un marketeur débordé ?

Pour répondre à ces questions, Benoit (Growth marketeur chez Plezi) a interviewé Orian Roturier (Head of Growth & Demand Generation chez GitGuardian). Si vous avez loupé ce Plezi Decode spécial A/B test, pas de panique : séance de rattrapage dans cet article.

Au programme :

- Qu’est ce que l’A/B testing : retour sur la définition de ce concept marketing

- Comment faire de l’A/B testing ?

- A/B test: les 5 erreurs les plus fréquentes

- L’A/B test en B2B : une (vraie) bonne idée ?

- Comment tester et améliorer ses actions marketing sans A/B test ?

Qu’est-ce que l’A/B Testing ?

L’A/B testing (aussi appelé A/B test ou split testing) est une méthode marketing pour comparer deux versions d’un même contenu. Orian Roturier parle aussi de “tester deux hypothèses d’une même variante”. Cette stratégie de testing peut être mise en place pour mesurer l’efficacité :

- D’un e-mail marketing

- D’une page d’accueil de site web

- D’une page produit

- D’une campagne publicitaire

- D’un formulaire d’inscription

- D’une landing page

- etc.

En marketing digital, l’A/B testing a pour objectif de mesurer l’impact d’un changement, et ses performances. Par exemple, prenons deux internautes : Paul et Marion. Aujourd’hui, ils décident tous les deux de visiter le site web d’un éditeur de logiciel SaaS.

Paul aura accès à la version originale du site web (“A”), et Marion à la version alternative (“B”). Ces variations d’un élément A à un élément B sont présentées aléatoirement à nos deux visiteurs, ainsi qu’à tout le trafic web. Ils auront accès à des éléments différents : arguments marketing, couleur des boutons, images, CTA ou encore structure de page.

Pendant la période de test, les données sont collectées et les comportements utilisateurs analysés… Pour valider certaines hypothèses sur les pages :

- Quelle page génère le plus de trafic web, entre les deux versions ?

- Quelle version du site web a le meilleur taux de conversion ?

- Combien de temps les visiteurs restent-ils en moyenne sur chaque page test ?

- Quel type de call-to-action (CTA) ou bouton sur-performe ?

- Quelle partie du tunnel de conversion sous-performe ?

L’enjeu final ? Implémenter la version gagnante du test, qui améliore l’expérience utilisateur et booste les conversions.

Mais avant d’en arriver là, encore faut-il savoir développer cette méthode de A à Z. Spoiler : ce n’est pas si simple.

Comment faire de l’A/B testing ?

Dans notre Plezi Decode dédié à l’A/B test, Orian Roturier nous l’a confirmé : se lancer dans les tests sans méthode cadrée… C’est foncer dans le mur, tête baissée.

Si vous souhaitez un jour déployer une telle approche marketing, commencez par suivre ces 3 étapes :

1. Définir un KPI clé

On a dit un. Pas quinze. Cet indicateur précis est à définir au singulier, pour (vraiment) réussir l’analyse de votre projet de testing.

Alors, quelle est votre priorité ? Taux d’ouverture d’émail, taux de clic sur un bouton type CTA, nombre de sign-ups sur une landing page, taux de conversion sur un site web…

C’est votre mission : choisir l’indicateur de performance le plus pertinent, et suivre les bonnes données lors des tests.

2. Tester les hypothèses

Prenons l’exemple d’une campagne d’e-mailing. La deuxième étape est de créer deux contenus, puis définir une hypothèse. Par exemple : “la version n°2 de l’e-mail va générer plus d’inscriptions”.

On retrouve ici l’indicateur de performance à atteindre (générer des inscriptions) et l’hypothèse à suivre (c’est la version n°2 de l’e-mail, qui performera le plus). Pour tester l’hypothèse, il est maintenant nécessaire de définir la “valeur P” : cette valeur indique la probabilité d’obtenir le résultat de conversion souhaité.

Un exemple de valeur-P : “je suis sûr à 95 % que la version n°2 de l’e-mail est meilleure que la version n°1 de l’e-mail”.

Si on recommence le test 100 fois, on devrait donc retrouver le même résultat 95 fois, lors de l’analyse.

3. Valider la taille de l’échantillon

La taille de l’échantillon correspond à la taille minimale obligatoire lors des tests, pour que vous puissiez dire “je suis sûr(e) de moi”.

Définir un échantillon trop petit, c’est prendre le risque que les résultats ne soient ni représentatifs, ni significatifs. En augmentant la taille de l’échantillon, les résultats reflètent plus fidèlement le comportement global des utilisateurs.

Pour calculer la taille de l’échantillon de votre test, Orian Roturier recommande d’utiliser l’outil d’Evan Miller. Prêts à passer à l’action ?

Pas si vite ! Suivre ces 3 étapes n’est qu’un début. La mise en place d’A/B tests est (parfois) un chemin long et sinueux, avec des résultats de conversions difficiles à mesurer. Surtout si vous commettez une ou plusieurs de ces erreurs…

A/B test : les 5 erreurs les plus fréquentes

L’A/B testing est une méthodologie rigoureuse, qui suit des lois mathématiques précises. Le problème ? Trop d’entreprises commettent des erreurs… Parfois même avant le lancement de l’expérience. En voici 5 à éviter :

1. Ne pas définir d’objectifs clairs

Nous l’avons vu : la définition d’un objectif via un KPI unique est une priorité. Avant de commencer le processus d’A/B testing, ces objectifs doivent être clairs.

Pensez SMART, avec un objectif Spécifique, Mesurable, Atteignable, Réaliste et Temporel. Autrement, difficile de créer une roadmap de tests pertinente, et d’atteindre des résultats performants.

Alors, quelle est votre priorité ? Augmenter le taux de clic ? Booster le taux de conversion ? Générer plus d’inscriptions utilisateurs ? Choisir, ce n’est pas renoncer… C’est mieux avancer !

2. Tester trop d’éléments en même temps

Vouloir trop en faire, c’est risquer de mal faire. Ça, c’est (surtout) vrai en marketing. Notamment lors d’un split testing (ou A/B testing). Vous voulez tester plusieurs variations en même temps, pour gagner du temps et obtenir de bons résultats rapidement ?

En réalité, vous risquez surtout de cumuler trop de résultats difficiles à interpréter et analyser. Ce qui génère une perte de temps conséquente, dont vous pourriez vous passer en tant que marketeur débordé.

Testez plutôt une seule variable à la fois, pour obtenir des conclusions fiables et exploitables. Puis, en fonction des données utilisateurs obtenues, faites preuve d’optimisation. Un test à la fois.

3. Ne pas prendre en compte la taille de l’échantillon

Nous l’avons vu ensemble : la taille (de l’échantillon), ça compte. La pire erreur est de se focaliser sur un volume de clients, de visiteurs ou de prospects trop faible. Les résultats sur vos deux versions différentes seront alors biaisés.

Avant de lancer l’expérience de testing, vous savez ce qu’il vous reste à faire : prendre le temps de définir votre taille d’échantillon. En général, on recommande de disposer d’au moins 1 000 contacts en B2B, pour commencer à obtenir des résultats de tests réalistes et représentatifs de la population cible.

Votre trafic est bien plus faible ? Vous n’avez pas encore une telle base de clients ou d’utilisateurs ? Ne perdez pas de temps à créer plusieurs versions d’un même contenu, de suivre cette méthode d’A/B test… Et concentrez d’abord vos efforts sur votre stratégie d’acquisition.

4. Effectuer un biais de sélection

La règle d’or du split testing est d’utiliser des groupes d’utilisateurs aléatoires. Vouloir choisir la répartition entre les groupes d’utilisateurs A et B revient à tricher… Ou en d’autres termes, effectuer un biais de sélection. Les conséquences ? Des résultats faussés. Une expérience de testing ratée.

Alors non, vous ne choisirez pas la clientèle qui recevra la version A de votre campagne d’e-mail marketing, ou le type d’utilisateur qui naviguera sur la version B de votre nouvelle page web. Faites confiance au pouvoir de l’aléatoire, lors de vos tests.

5. Arrêter le test trop tôt

Certains mettent la charrue avant les bœufs… Et d’autres disent stop trop tôt, avant la fin du jeu. Nous ne recommandons ni l’un, ni l’autre. Il est indispensable de laisser la phase de test se dérouler suffisamment longtemps, pour obtenir des résultats pertinents.

Arrêter le test quelques jours après son lancement, c’est se fier à des conclusions erronées ou incomplètes. La marche à suivre, c’est plutôt d’atteindre un indice de confiance d’au moins 95 %, pour assurer une bonne fiabilité statistique.

Cet indice de confiance permet de connaître le pourcentage de chances d’obtenir des résultats réalistes. Pour y parvenir, une durée de tests comprise entre 1 et 3 semaines est généralement nécessaire.

Vous l’avez compris : faire un A/B test raté, c’est pire que de ne pas faire de tests du tout.

Alors, faut-il vraiment s’y risquer ?

L’A/B test en B2B : une (vraie) bonne idée ?

Vous savez maintenant tout de l’A/B test. Ou presque. Une question reste en suspens : pour les entreprises BtoB, un A/B test rime-t-il avec bonne idée ?

La réponse dépend avant tout de la taille de l’entreprise. Pour des mastodontes du BtoB comme Salesforce, SAP ou Deloitte… C’est une stratégie efficace.

Mais pour une entreprise BtoB avec des ressources à taille humaine (aka. moins de 5 personnes l’équipe marketing), cette méthode de tests d’optimisation devient vite inadaptée. Voire dangereuse, puisque vous risquez grandement de baser vos décisions sur de faux résultats, ou des éléments non-représentatifs.

Vous subissez alors les effets inverses de la loi de Pareto. Alors que 20 % de vos efforts sont censés générer 80 % des résultats, l’A/B test vous amène à déployer 80 % d’efforts pour (seulement) 20 % de résultats. C’est peu, pour obtenir des performances qui boostent la croissance.

Alors, en tant que marketeur débordé, vous n’avez pas (forcément) besoin d’A/B test. Oui, il est possible de livrer de bonnes campagnes marketing… Sans passer par l’A/B testing. On vous explique ?

Comment tester et améliorer ses actions marketing sans A/B test ?

Nous le répétons : l’A/B test comme solution, ce n’est pas une obligation. D’autres alternatives plus simples et efficaces existent, pour tester, optimiser et valider vos actions.

Notre recommandation ? Lancer, analyser, modifier, analyser. Puis répéter.

Cette approche d’amélioration continue fonctionne pour vos différents supports marketing.

1. L’e-mailing

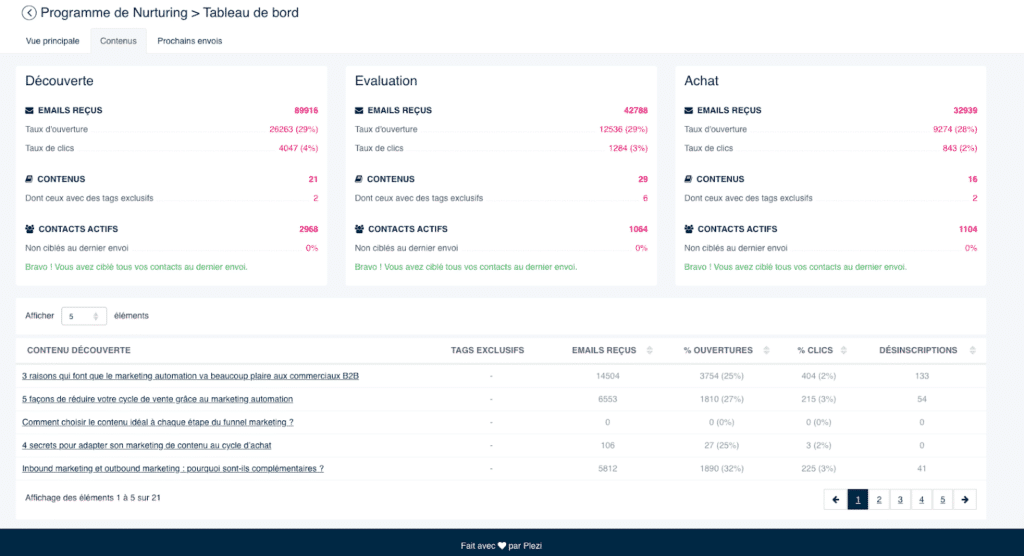

Après avoir lancé une campagne d’e-mail marketing, analysez les retombées. Puis, n’hésitez pas à optimiser. Chez Plezi, ça donne ça :

Après chaque envoi de newsletter, on varie le ton des objets d’e-mail. On profite également de notre campagne intelligente pour analyser la performance des contenus poussés à nos contacts.

Tableau de bord de la campagne intelligente de Plezi

Pour les contenus web avec des taux d’ouverture et de clic trop faibles, on met en place des changements de wording (objets, corps du texte, etc.). Puis on renvoie l’e-mail aux clients deux semaines après. Dernière étape : suivre et analyser les résultats, grâce à des outils comme Plezi. Pour effectuer (ou non) de nouvelles optimisations.

À votre tour, vous souhaitez utiliser la campagne intelligente pour booster vos actions marketing ? Voici ce que vous pouvez changer et tester :

- Objet

- Type d’e-mail (marketing, e-mail brandé ou e-mail texte)

- Contenu de l’e-mail

- Tonalité

- CTA et boutons

- Design de l’émail

Pour aller plus loin, découvrez nos 11 astuces pour rédiger le parfait e-mail de nurturing

2. Site web ou landing page

Pour améliorer les performances de vos landing pages (ou pages de site web), nous vous conseillons de les analyser et de les optimiser dans la durée. Chez Plezi, nous avons remarqué que les bonnes landing pages (ou pages ayant pour but premier de convertir) doivent vous assurer un taux de conversion de 10 % minimum.

Si ce n’est pas le cas, place à l’analyse. Vous pouvez notamment :

- Installer des heatmaps (outils de zone de chaleur), pour mieux comprendre le comportement des utilisateurs sur les pages. Notre recommandation d’outils : Hotjar ou Microsoft Clarity.

- Mettre un UTM dans le lien de la page, pour suivre les sources de trafic des visiteurs.

- Changer et tester un nouveau contenu sur la page, le format et la disposition des éléments, le design des éléments, la couleur des boutons et leur emplacement, de nouveaux call-to-actions (CTA), etc.

Editeur de landing page de Plezi

Si le problème persiste, c’est qu’il est peut-être temps de revoir la cohérence de votre parcours client… Et de repenser la création de votre page de A à Z, en suivant nos conseils et exemples pour une landing page efficace.

3. Campagnes publicitaires

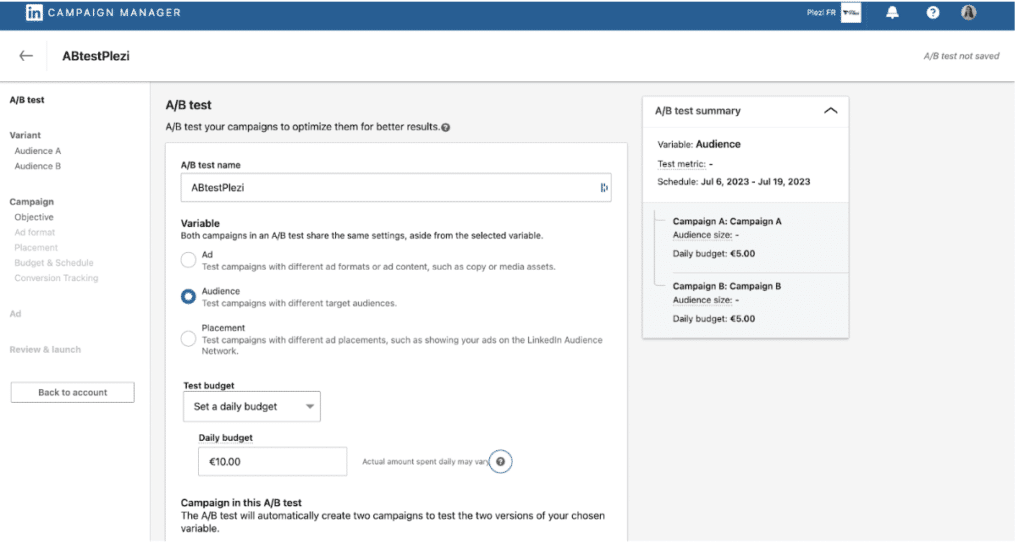

Pour tester de nouveaux messages, les campagnes publicitaires sont idéales.

Investir quelques dizaines d’euros dans une campagne Google Ads, Facebook Ads ou LinkedIn Ads vous aide à tirer des conclusions intéressantes. D’autant plus que les outils publicitaires mettent à votre disposition des fonctionnalités natives, pour faciliter la création, le paramétrage et la publication des publicités.

Prenons l’exemple de LinkedIn Ads. Depuis votre espace Campaign Manager, vous pouvez :

- Tester différentes tailles d’audiences, de la plus restreinte à la plus large… Et choisir des critères de ciblage spécifiques, pour choisir à qui adresser les messages marketing.

- Varier les tonalités, entre vos différentes publicités. Chez Plezi, nous avons déjà associé à nos campagnes des visuels humoristiques, des rébus… Avant de nous concentrer sur une tonalité qui nous ressemble plus (un petit tour sur notre page LinkedIn, pour la découvrir ?)

- Jouer avec les différents formats de LinkedIn Ads : images, carrousels, textes, vidéos… Chez Plezi, on teste depuis quelques mois le format “Document Ads” dans nos campagnes LinkedIn. Résultats ? Ce test est déjà concluant : en quelques semaines seulement, ce format est devenu un de nos tops contenus, pour générer des leads en campagne d’acquisition froide.

Cependant, attention à la qualité du trafic web, en utilisant des campagnes publicitaires qui jouent sur le volume. Les performances des campagnes doivent être analysées avec précision, pour limiter les résultats contre-productifs.

Vous savez maintenant ce qu’il vous reste à faire :

Faites l’impasse sur l’A/B testing

Un mythe s’effondre. Non, en BtoB, vous n’avez pas besoin d’A/B test pour performer. Pour améliorer votre stratégie marketing, nous l’avons vu dans cet article… D’autres techniques d’amélioration continue existent.

Souvenez-vous : votre temps est précieux. Alors, autant l’utiliser pour faire passer votre marketing à la vitesse supérieure. Par exemple, grâce au déploiement d’une solution de marketing automation, qui automatise vos tâches répétitives et vous fait gagner une semaine de travail par mois :